- חוקה ויסודות המשטר

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

הצעת חוק-יסוד: השפיטה (תיקון מס' 3) והצעת חוק בתי המשפט (תיקון מס' 101), התשפ"ג-2023

ד"ר אלעד גיל

|26.02.2025

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

"תיקון חוק יסוד השפיטה – הרכב הוועדה לבחירת שופטים": מורה נבוכים

עמנואל הירשפלד טרכטינגוט

|20.04.2025

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

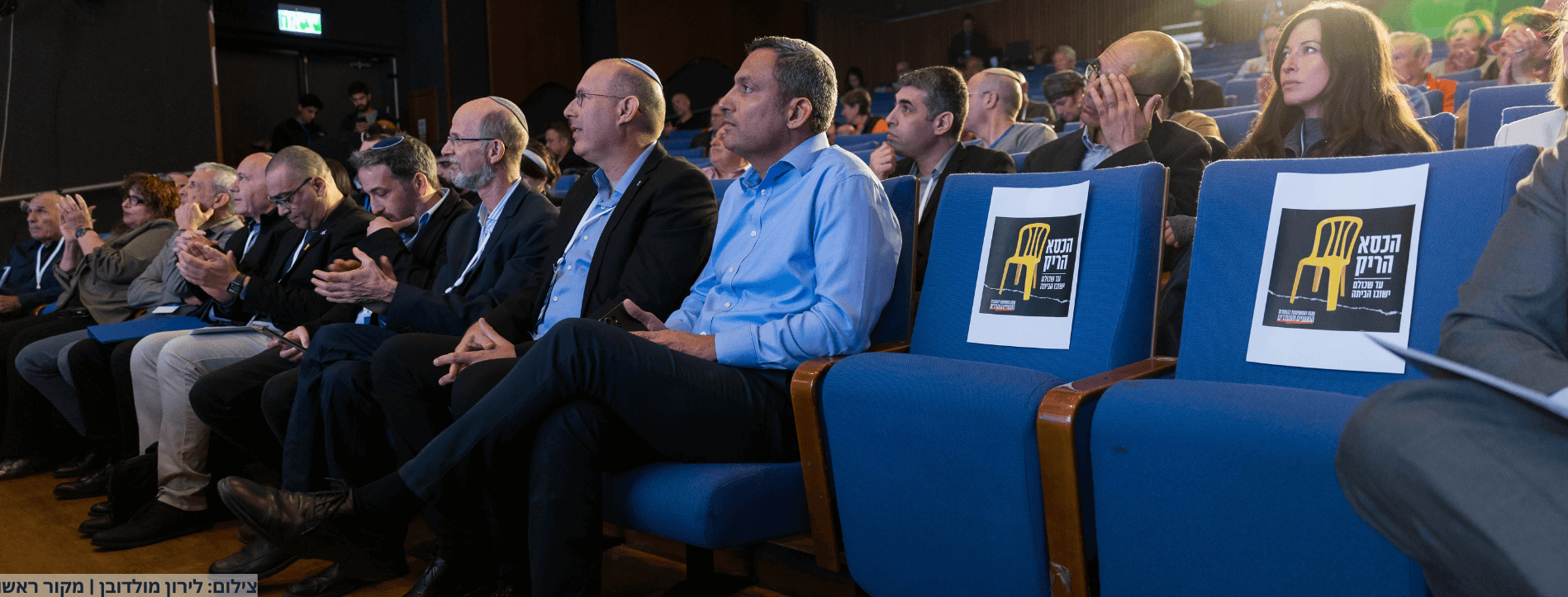

"תיקון חוק יסוד השפיטה – הרכב הוועדה לבחירת שופטים": מורה נבוכים

עמנואל הירשפלד טרכטינגוט

|20.04.2025

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- ממשל ושירות ציבורי

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

הצעת חוק הרשויות המקומיות (זכויות וחובות של חברי מועצה), התשפ"ג-2023

עו"ד ד"ר מורן נגיד

|01.06.2025

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- החברה הישראלית

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

שאלות ותשובות על המדריך לניהול סיכונים ושימוש אחראי בבינה מלאכותית במגזר הציבורי

מאורי הירש מרקסון

|24.07.2025

- הכנסת

- חוקה ויסודות המשטר

- זרקור

- נושאים נוספים

- ממשל ושירות ציבורי

ד"ר אלעד גיל

|14.08.2025

- חוות דעת

- החברה החרדית

- החברה הישראלית

- זרקור

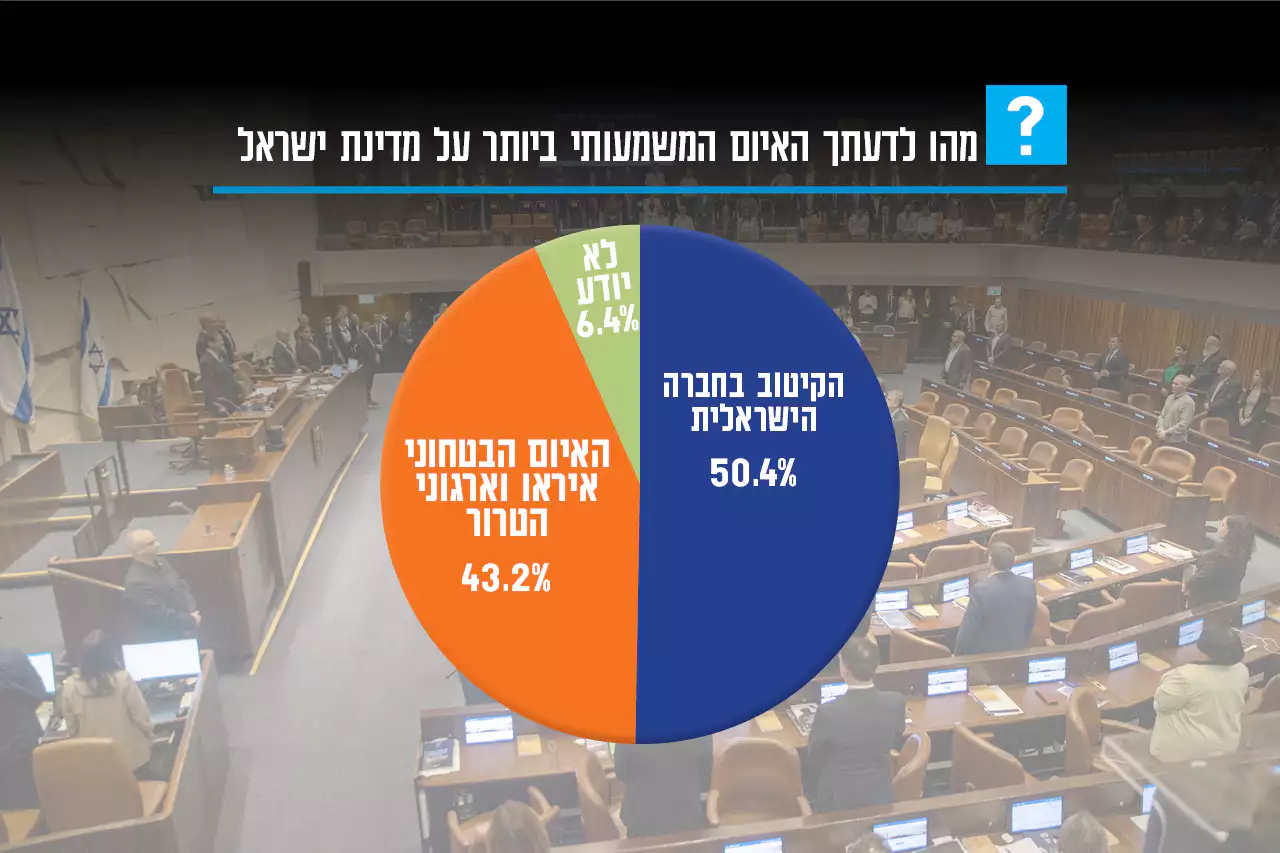

- "אחד העם"

- מחקרי דעת קהל