- חוקה ויסודות המשטר

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

"תיקון חוק יסוד השפיטה – הרכב הוועדה לבחירת שופטים": מורה נבוכים

עמנואל הירשפלד טרכטינגוט

|20.04.2025

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- ממשל ושירות ציבורי

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

הצעת חוק הרשויות המקומיות (זכויות וחובות של חברי מועצה), התשפ"ג-2023

עו"ד ד"ר מורן נגיד

|01.06.2025

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה הישראלית

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

שאלות ותשובות על המדריך לניהול סיכונים ושימוש אחראי בבינה מלאכותית במגזר הציבורי

מאורי הירש מרקסון

|24.07.2025

- החברה החרדית

- החברה הישראלית

- זרקור

- חברה וטכנולוגיה

- החברה הישראלית

- זרקור

- נושאים נוספים

- חוקה ויסודות המשטר

- בתקשורת

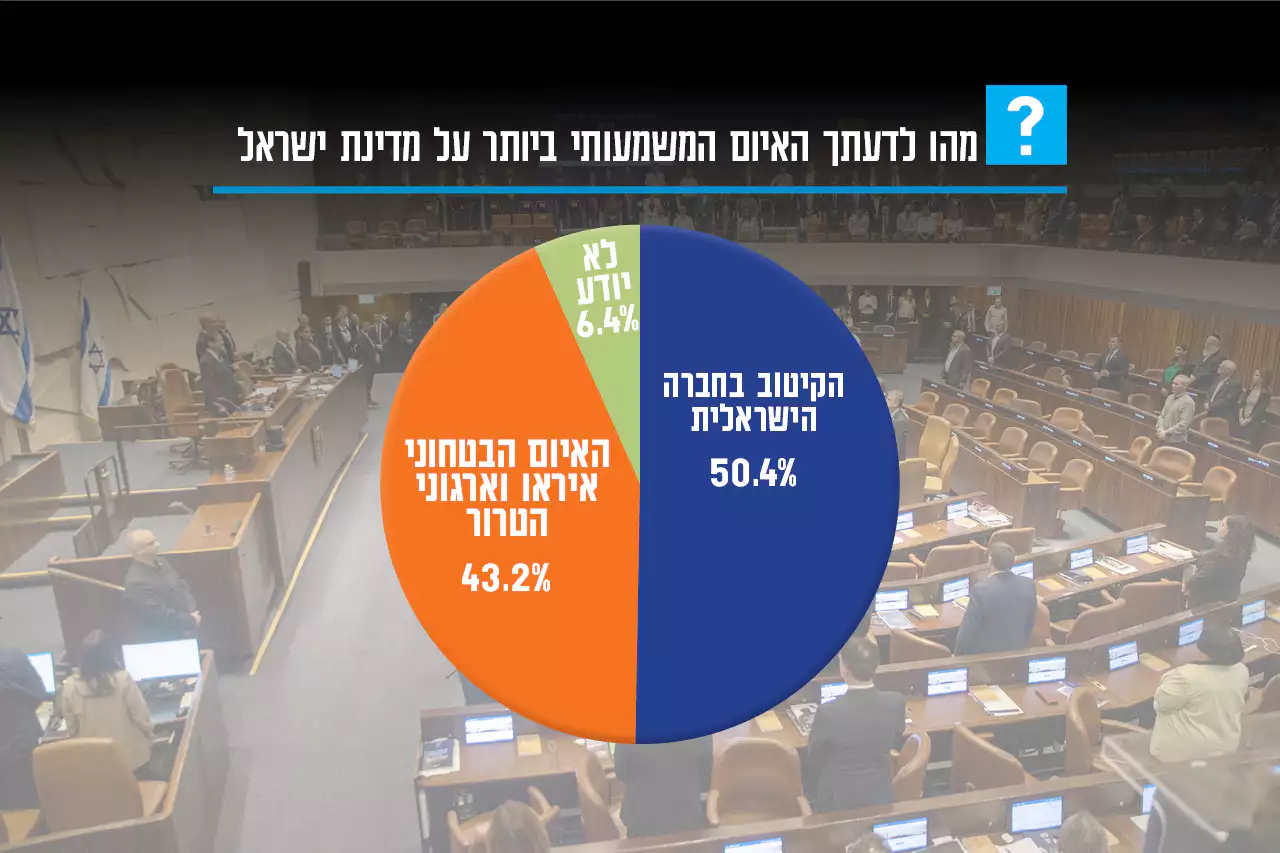

- "אחד העם"

- מחקרי דעת קהל

בניגוד לגישת האסדרה העולה מהצעת הרגולציה של האיחוד האירופי, המדיניות המשתקפת בישראל ממסמך העקרונות של משרד החדשנות היא שאין לקדם חקיקת מסגרת רגולטורית רוחבית על כל תחום הבינה המלאכותית וכי הרגולטורים השונים יידרשו לבחון את הצורך בקידום רגולציה קונקרטית בתחומם.

בניגוד לגישת האסדרה העולה מהצעת הרגולציה של האיחוד האירופי, המדיניות המשתקפת בישראל ממסמך העקרונות של משרד החדשנות היא שאין לקדם חקיקת מסגרת רגולטורית רוחבית על כל תחום הבינה המלאכותית וכי הרגולטורים השונים יידרשו לבחון את הצורך בקידום רגולציה קונקרטית בתחומם.